Koha e parashikuar e leximit: 11 minuta

30 shtator 2025

Ekspertët shpjegojnë çfarë dimë ne rreth emetimeve të modelit të inteligjencës artificiale dhe çfarë mund të bëni për të ndihmuar.

Një chatbot mund të mos bëjë shumë punë sa herë që i kërkoni të bëjë listën tuaj të blerjeve ose të shpikë shakatë më të mira për baballarët. Por me kalimin e kohës, planeti mund ta bëjë këtë.

Ndërsa IA gjeneruese, siç janë modelet e mëdha gjuhësore (LLMS), bëhet gjithnjë e më e përhapur, lindin pyetje kritike. Për çdo ndërveprim që keni me IA-në, sa energji merr ajo – dhe sa karbon emetohet në atmosferë?

Në qershor, drejtori ekzekutiv i OpenAI, Sam Altman, deklaroi se një pyetje “mesatare” në ChatGPT përdor energji të barabartë me “përafërsisht atë që do të përdorte një furrë në pak më shumë se një sekondë”. Kjo është brenda sferës së arsyes: firma kërkimore e inteligjencës artificiale Epoch AI më parë kishte llogaritur një vlerësim të ngjashëm . Megjithatë, ekspertët thonë se pretendimit i mungon konteksti kyç, si për shembull se çfarë është një pyetje “mesatare”.

«Nëse do të donit të ishit rigoroz në lidhje me këtë, do të duhej të jepnit një diapazon», thotë Sasha Luccioni, një studiuese e inteligjencës artificiale dhe drejtuese e klimës në firmën e inteligjencës artificiale Hugging Face. «Nuk mund të jepni thjesht një numër atje.»

Lojtarë të mëdhenj, përfshirë OpenAI dhe Anthropic, kanë të dhënat, por nuk po i ndajnë ato . Në vend të kësaj, studiuesit mund të mbledhin vetëm të dhëna të kufizuara nga LLM-të me burim të hapur. Një studim i botuar më 19 qershor në Frontiers in Communication shqyrtoi 14 modele të tilla , duke përfshirë ato nga Meta dhe DeepSeek, dhe zbuloi se disa modele prodhuan deri në 70 herë më shumë emetime CO₂ sesa të tjerët.

Por këto shifra ofrojnë vetëm një pamje të shkurtër — dhe ato bëhen edhe më të tmerrshme pasi llogaritet kostoja e karbonit e modeleve të trajnimit, prodhimi dhe mirëmbajtja e pajisjeve për t’i përdorur ato dhe shkalla në të cilën IA gjeneruese është e gatshme të përshkojë jetën tonë të përditshme.

“Hulumtimi i të mësuarit automatik është nxitur nga saktësia dhe performanca”, thotë Mosharaf Chowdhury, një shkencëtar kompjuterash në Universitetin e Miçiganit në Ann Arbor. “Energjia ka qenë fëmija i mesëm për të cilin askush nuk dëshiron të flasë.”

Science News foli me katër ekspertë për të zbardhur këto kosto të fshehura dhe çfarë nënkuptojnë ato për të ardhmen e inteligjencës artificiale.

Çfarë i bën modelet e mëdha gjuhësore kaq të etura për energji?

Shpesh do të dëgjoni njerëz që i përshkruajnë LLM-të sipas numrit të parametrave që kanë. Parametrat janë çelësat e brendshëm që modeli rregullon gjatë trajnimit për të përmirësuar performancën e tij. Sa më shumë parametra, aq më shumë kapacitet ka modeli për të mësuar modele dhe marrëdhënie në të dhëna. Për shembull, thuhet se GPT-4 ka mbi një trilion parametra.

«Nëse doni të mësoni të gjithë njohuritë e botës, ju nevojiten modele gjithnjë e më të mëdha», thotë shkencëtari i kompjuterave në MIT, Noman Bashir.

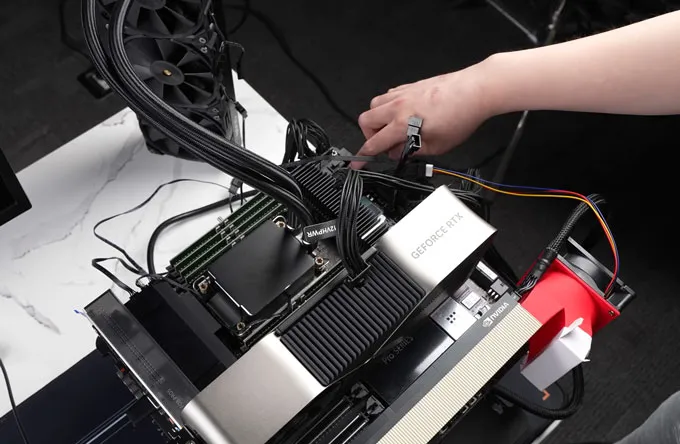

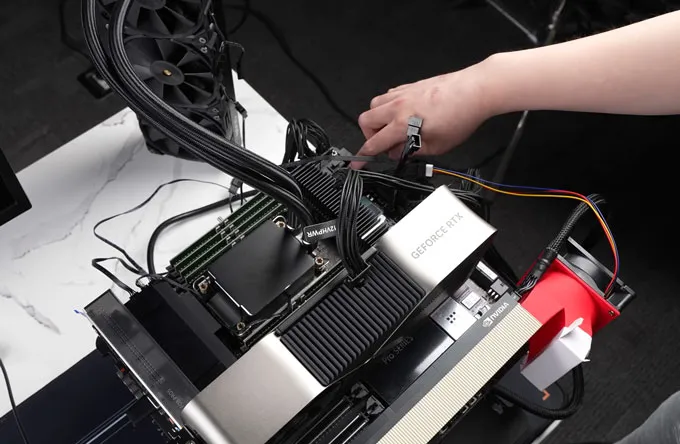

Modele të tilla nuk funksionojnë në laptopin tuaj. Në vend të kësaj, ato vendosen në qendra masive të të dhënave të vendosura në të gjithë botën. Në secilën qendër, modelet ngarkohen në servera që përmbajnë çipa të fuqishëm të quajtur njësi përpunimi grafik (GPU), të cilët bëjnë përpunimin e numrave të nevojshëm për të gjeneruar rezultate të dobishme. Sa më shumë parametra të ketë një model, në përgjithësi aq më shumë çipa nevojiten për ta ekzekutuar atë – veçanërisht për t’u dhënë përdoruesve përgjigjen më të shpejtë të mundshme.

E gjithë kjo kërkon energji. Tashmë, 4.4 përqind e të gjithë energjisë në SHBA shkon drejt qendrave të të dhënave që përdoren për një sërë kërkesash teknologjike, përfshirë inteligjencën artificiale. Deri në vitin 2028, ky numër parashikohet të rritet deri në 12 përqind.

Pse është kaq e vështirë të matet gjurma e karbonit e LLM-ve?

Para se dikush t’i bëjë një pyetje një modeli, ai duhet të trajnohet së pari. Gjatë trajnimit, një model përpunon grupe të mëdha të dhënash dhe rregullon parametrat e tij të brendshëm në përputhje me rrethanat. Mund të duhen javë dhe mijëra GPU, duke djegur një sasi të madhe energjie. Por, meqenëse kompanitë rrallë i zbulojnë metodat e tyre të trajnimit – çfarë të dhënash përdorën, sa kohë llogaritëse ose çfarë lloj energjie e ka mundësuar atë – emetimet nga ky proces janë kryesisht një kuti e zezë.

Gjysma e dytë e ciklit jetësor të modelit është nxjerrja e përfundimeve, e cila ndodh sa herë që një përdorues e nxit modelin. Me kalimin e kohës, pritet që nxjerrja e përfundimeve të përbëjë pjesën më të madhe të emetimeve të një modeli. “Ti e trajnon një model një herë, pastaj miliarda përdorues e përdorin modelin kaq shumë herë”, thotë Chowdhury.

Por edhe nxjerrja e përfundimeve është e vështirë të përcaktohet në mënyrë sasiore. Ndikimi mjedisor i një pyetjeje të vetme mund të ndryshojë në mënyrë dramatike në varësi të qendrës së të dhënave në të cilën drejtohet, rrjetit të energjisë që furnizon me energji qendrën e të dhënave dhe madje edhe orës së ditës. Në fund të fundit, vetëm kompanitë që përdorin këto modele kanë një pamje të plotë.

A ka ndonjë mënyrë që studiuesit e pavarur të përcaktojnë përdorimin e energjisë nga një LLM?

Për stërvitje, jo tamam. Për të nxjerrë përfundime, pak a shumë.

OpenAI dhe Anthropic i mbajnë modelet e tyre si pronë të pronarit, por kompani të tjera si Meta dhe DeepSeek publikojnë versione me burim të hapur të produkteve të tyre të IA-së. Studiuesit mund t’i ekzekutojnë këto modele në nivel lokal dhe të matin energjinë e konsumuar nga GPU-ja e tyre si një përfaqësim për sasinë e energjisë që do të duhej për të nxjerrë përfundime.

Në studimin e tyre të ri, Maximilian Dauner dhe Gudrun Socher në Universitetin e Shkencave të Aplikuara të Mynihut në Gjermani testuan 14 modele të inteligjencës artificiale me burim të hapur, që varionin nga 7 miliardë deri në 72 miliardë parametra (ato çelësa të brendshëm), në GPU-në NVIDIA A100. Modelet e arsyetimit, të cilat shpjegojnë të menduarit e tyre hap pas hapi, konsumuan shumë më tepër energji gjatë nxjerrjes së përfundimeve sesa modelet standarde, të cilat nxjerrin drejtpërdrejt përgjigjen.

Arsyeja qëndron te tokenët, ose pjesët e tekstit që një model përpunon për të gjeneruar një përgjigje. Më shumë tokena nënkuptojnë më shumë llogaritje dhe përdorim më të lartë të energjisë. Edhe kur u përgjigjen pyetjeve të thjeshta me zgjedhje të shumëfishta, modelet e arsyetimit mesatarisht përdorën 543.5 tokena shtesë për pyetje përveç 37.7 tokenave të modeleve standarde. Në shkallë të gjerë, pyetjet shtohen: Përdorimi i modelit të arsyetimit DeepSeek R1 me 70 miliardë parametra për t’iu përgjigjur 500,000 pyetjeve do të emetonte aq CO₂ sa një fluturim vajtje-ardhje nga Londra në Nju Jork.

Në realitet, numrat mund të jenë vetëm më të lartë. Shumë kompani kanë kaluar në çipin më të ri H100 të Nvidia-s, një çip i optimizuar posaçërisht për ngarkesat e punës së IA-së që është edhe më i etur për energji sesa A100. Për të pasqyruar më saktë energjinë totale të përdorur gjatë nxjerrjes së përfundimeve – duke përfshirë sistemet e ftohjes dhe pajisjet e tjera mbështetëse – hulumtimet e mëparshme kanë zbuluar se konsumi i raportuar i energjisë së GPU-së duhet të dyfishohet .

Megjithatë, asnjë nga këto nuk shpjegon emetimet e gjeneruara nga prodhimi i pajisjeve dhe ndërtimi i ndërtesave ku ato ndodhen, atë që njihet si karbon i mishëruar, thekson Bashir.

Nvidia H100 është optimizuar posaçërisht për ngarkesat e punës me inteligjencën artificiale – dhe është edhe më e konsumueshme në energji sesa paraardhësit e saj.极客湾Geekerwan/Wikimedia Commons

Çfarë mund të bëjnë njerëzit për ta bërë përdorimin e inteligjencës artificiale më miqësore me mjedisin?

Zgjedhja e modelit të duhur për secilën detyrë bën diferencën. “A është gjithmonë e nevojshme të përdoret modeli më i madh për pyetje të lehta?” pyet Dauner. “Apo një model i vogël mund t’u përgjigjet edhe pyetjeve të lehta, dhe ne mund të zvogëlojmë emetimet e CO₂ bazuar në këtë?”

Në mënyrë të ngjashme, jo çdo pyetje ka nevojë për një model arsyetimi. Për shembull, studimi i Dauner zbuloi se modeli standard Qwen 2.5 arriti saktësi të krahasueshme me modelin e arsyetimit Cogito 70B, por me më pak se një të tretën e prodhimit të karbonit.

Studiuesit kanë krijuar mjete të tjera publike për të matur dhe krahasuar përdorimin e energjisë së IA-së. Hugging Face drejton një tabelë renditjeje të quajtur AI Energy Score , e cila rendit modelet bazuar në sasinë e energjisë që përdorin në 10 detyra të ndryshme, nga gjenerimi i tekstit te klasifikimi i imazhit e deri te transkriptimi i zërit. Ai përfshin modele me burim të hapur dhe modele pronësore. Ideja është të ndihmohen njerëzit të zgjedhin modelin më efikas për një punë të caktuar, duke gjetur atë “pikë të artë” midis performancës, saktësisë dhe efikasitetit të energjisë.

Chowdhury ndihmon gjithashtu në drejtimin e ML.Energy, i cili ka një renditje të ngjashme . “Mund të kurseni shumë energji duke hequr dorë nga pak performancë”, thotë Chowdhury.

Përdorimi më pak i inteligjencës artificiale gjatë ditës ose verës, kur kërkesa për energji rritet ndjeshëm dhe sistemet e ftohjes punojnë jashtë orarit, mund të bëjë gjithashtu një ndryshim. “Është e ngjashme me kondicionerin,” thotë Bashir. “Nëse temperatura e jashtme është shumë e lartë, do t’ju duhet më shumë energji për të ftohur pjesën e brendshme të shtëpisë.”

Edhe mënyra se si i formuloni pyetjet tuaja ka rëndësi. Nga ana mjedisore, nuk ka nevojë të jeni të sjellshëm me chatbot-in. Çdo informacion shtesë që jepni kërkon më shumë fuqi përpunimi për t’u analizuar. “Kushton miliona dollarë [shtesë] për shkak të ‘faleminderit’ dhe ‘ju lutem’,” thotë Dauner. “Çdo fjalë e panevojshme ka një ndikim në kohën e ekzekutimit.”

Megjithatë, në fund të fundit, politika duhet të arrijë ritmin. Luccioni sugjeron një kornizë të bazuar në një sistem vlerësimi të energjisë, si ato që përdoren për pajisjet shtëpiake. Për shembull, “nëse modeli juaj përdoret, le të themi, nga 10 milionë përdorues në ditë ose më shumë, ai duhet të ketë një rezultat energjie B+ ose më të lartë”, thotë ajo.

Përndryshe, furnizimi me energji nuk do të jetë në gjendje të përballojë kërkesën në rritje të IA-së. “Unë shkoj në konferenca ku operatorët e rrjetit po tmerrohen”, thotë Luccioni. “Kompanitë teknologjike nuk mund të vazhdojnë ta bëjnë këtë. Gjërat do të fillojnë të shkojnë keq.”